En 2009, Hal Varian, economista jefe de Google y uno de los grandes microeconomistas vivos, afirmaba en una fascinante entrevista que el “trabajo sexy” de los próximos 10 años sería la estadística. Una de las miserias que el terremoto financiero había dejado al descubierto fue la ingente cantidad de talento que los grandes bancos de inversión habían acaparado: muchos licenciados en física y matemáticas entraban en másteres de economía o negocios atraídos por los salarios de Wall Street. En vez de esforzarse en hacer más eficientes algoritmos vitales para la vida moderna, muchas de las mentes más brillantes de dicha generación se dedicaron a diseñar productos financieros capaces de pasar el “control de seguridad” de las agencias de calificación mientras comprimían una cantidad absurda de riesgo en una caja negra que finalmente escapó a su control.

Desde las declaraciones de Varian y el colapso financiero, el interés por todo lo relacionado con la estadística ha ido aumentando, tanto a escala individual (“¿Cómo puedo formarme para trabajar como Data Scientist?”) como a nivel social, en la medida en que el Big Data promete ser la siguiente gran revolución productiva; así lo plasmaba Alberto Artero en un reciente artículo (“La Tercera Revolución Industrial”). No obstante, y a pesar del enorme entusiasmo de los autores con la materia, nos gustaría dar una visión mucho más conservadora respecto a la posibilidad de que los datos lideren en el corto plazo una verdadera revolución industrial y del impacto que puede tener sobre la economía de nuestro país.

El primer motivo es que no hay nada fundamentalmente novedoso en el Big Data. De hecho, dicha denominación no es más que un gancho comercial para denominar a la estadística que siempre hemos conocido. Ello no quiere decir que durante las últimas dos décadas no se hayan producido avances en las técnicas estadísticas y en cómo los expertos enfocan los problemas, pero el cambio ha sido y será, como casi siempre, gradual. Es decir, la revolución no será mucho más rápida que la que ya estamos viviendo… ¡lo cual no quiere decir que no sea importante!

Quizás el aspecto más novedoso del nuevo paradigma se encuentra en el volumen de la materia prima de todo análisis: los datos. Aquí sí estamos presenciando en cierto modo una revolución, por el crecimiento de la magnitud de información que el ser humano es capaz de generar y almacenar. En 2010 se han generado unos 800exabytes de nueva información. Para poner dicha cifra en perspectiva, desde el inicio de los tiempos hasta 2005 el ser humano había almacenado unos 5 exabytes, cantidad que hoy se genera cada dos días. Y, en este aspecto, desde el más acérrimo fan de Hayek hasta el más recalcitrante comunista están de acuerdo en el valor de la información -los primeros argumentan que el sistema de precios es la institución espontánea más importante que ha creado el hombre, pues permite agregar información dispersa sin necesidad de una intención explícita; los segundos pretenden optimizar una función de utilidad individual para dar “a cada cual según su necesidad”-. ¿Dónde está entonces el problema con el Big Data?

Primer problema: nuestra capacidad de modelización es muy reducida

Una característica distintiva del Big Data es que se refiere generalmente a la posibilidad de modelizar y predecir ciertos comportamientos del ser humano. La nueva información que cada día se genera no se trata de nuevos datos de observaciones astronómicas o reacciones químicas, sino del rastro que deja en la red la acción humana, el cual puede ser fácilmente recolectado para su posterior análisis. Pero las novelas de Asimov y el cine de Hollywood se han encargado de transmitir una idea excesivamente optimista de nuestra capacidad real de modelización de fenómenos sociales o conductuales complejos. Una cosa es un experimento de laboratorio con 50 estudiantes de una misma universidad, del cual se puede extraer un patrón medio de comportamiento generando grupos de forma aleatoria, y otra muy distinta es que los investigadores puedan, a partir de información de la vida real, generar un modelo estructural de comportamiento que permita predecir la reacción de ciudadanos o clientes a determinadas medidas.

Allí donde una empresa o gobierno pueda generar experimentos, asignando clientes o ciudadanos aleatoriamente a distintos grupos, podrá tener una cierta certeza del efecto de una medida concreta. Por ejemplo, una cadena de supermercados puede experimentar con la respuesta del consumidor a cambios en los precios de algún producto seleccionando aleatoriamente la mitad de los supermercados de una ciudad y aplicando en ellos una rebaja. La selección aleatoria garantiza en este caso que el cambio de comportamiento se debe exclusivamente al efecto de la medida.

Pero este tipo de experimentos ya son fáciles de realizar desde hace décadas. Lo distintivo del Big Data es la recolección de datos de comportamiento real, y el problema aquí se encuentra en que las personas actúan por motivos muy complejos y en que ninguna “asignación a un grupo u otro” es aleatoria. ¿Está extraída de la misma muestra la gente que compra el pan en El Corte Inglés y quien lo compra en un supermercado Dia? Aquí es donde nuestra capacidad de modelización se topa con un muro de indescriptible complejidad, en el que un tratamiento ingenuo de la realidad puede llevar a conclusiones tremendamente erróneas.

Piensen en el clásico ejemplo de la mayor longevidad de los bebedores de vino sobre los de cerveza. La interpretación ingenua lleva a concluir que el vino aumenta la longevidad (o que la cerveza la acorta), pero bastan unos segundos para darse cuenta de que el comprador medio de vino es muy distinto del comprador de cerveza, y que su renta y hábitos de salud también difieren mucho. Si un ejemplo tan sencillo puede llevar a conclusiones erróneas, ¿qué no sucederá con fenómenos complejos en los que actúan simultáneamente varios factores? Imagine una enorme base de datos de impagos crediticios con información sobre renta, historial crediticio, localización, patrimonio, formación, sexo, etc. Arrojar todas las variables a un modelo múltiple para intentar predecir la probabilidad de un futuro impago devolverá medias condicionales, pero no habrá abordado la cuestión clave de todo análisis basado en datos no experimentales: la “endogeneidad”, esto es, el hecho de que la causalidad corre en varios sentidos y que las variables explicativas dependen unas de otras. Solo un modelo estructural explícito puede resolver este problema, pero ¿cuánta gente hay en el mundo capaz de plantearlo y contrastarlo? No pierdan tiempo buscando: realmente muy poca, y ellos mismos les dirán que aún tienen un amplio camino por recorrer.

En la medida en que los datos estén obtenidos de comportamientos reales, la complejidad del proceso será un muro difícil de franquear. Así, la capacidad de modelización a partir de bases de datos masivas, por prometedora que sea, es por ahora solo una quimera para el 99% del tejido productivo. Salvo algunas grandes compañías -solo Google o Facebook saben qué uso pueden estar haciendo con toda la información que recolectan-, el resto ha de conformarse con aprender gradualmente, aunque sí podrán beneficiarse de los incrementos de productividad que, por ejemplo, Google les pueda aportar.

Segundo problema: el Big Data solo es complementario con un tipo de capital humano muy específico

La intuición de este problema es sencilla: así como la revolución del motor de explosión fue posible por su complementariedad con cualquier tipo de trabajo –hasta el trabajador menos formado es mucho más productivo cavando una zanja con un martillo neumático-, los datos solo se complementan bien con una combinación de habilidades terriblemente escasa en la sociedad. Un “trabajador de los datos” necesita combinar tres tipos de conocimientos:

1. Estadística pura y dura. Modelos lineales, generalizados, máxima verosimilitud, contraste de hipótesis, inferencia, machine learning… Casi todo el mundo puede aprender las matemáticas necesarias, pero lo cierto es que, a día de hoy, menos del 1% de la población tiene el conocimiento suficiente para comprender un modelo estadístico y sus implicaciones.

2. Habilidades computacionales. Trabajar con datos masivos requiere en primer lugar la capacidad para manejarlos, e implementar modelos y algoritmos requiere soltura al menos en un lenguaje. Los paquetes estadísticos clásicos parecen estar perdiendo fuelle ante el empuje de herramientas open-source como R o Python, en las cuales la propia comunidad implementa en cuestión de días cualquier nueva funcionalidad. La buena noticia es que nunca fue tan fácil aprender a programar, gracias a la explosión de los cursos online.

3. Profundo conocimiento del tema a tratar. Este problema es, en esencia, el mismo al que con anterioridad nos referimos con el término “endogeneidad”, y es precisamente el mismo motivo por el que las suites de Business Intelligence han dado mucho menos de lo que prometían. Ningún modelo ni algoritmo puede garantizar predicciones fiables sin un conocimiento profundo del tema, es decir, sin un marco teórico sobre el que plantear el mismo. No existe una caja negra a la que podamos arrojar una tonelada de datos de la cual saldrá un patrón de comportamiento fiable. Además, las habilidades de modelización suelen adquirirse en el mundo académico, y allí donde el trasvase entre la academia y la empresa es fluido –siendo el ejemplo paradigmático el conglomerado Silicon Valley + Stanford + Caltech– los resultados son maravillosos. Pero allí donde la Universidad vive en un mundo paralelo y alejado de la excelencia, los resultados son nulos.

La conjunción de estas habilidades es hoy, y más en España, muy escasa (en nuestro caso habría que añadir las dificultades con el inglés). ¿Quién se beneficiará entonces de las nuevas posibilidades que traen los datos? ¿En qué medida esta nueva oportunidad puede dar a luz a un nuevo paradigma económico? Estas reflexiones nos llevan a las dos conclusiones que cierran este artículo.

Conclusión 1

Como anunciaba Hal Varian, el Big Data será muy provechoso para los trabajadores que reúnan las capacidades necesarias…, pero no necesariamente para el resto. Cuando una nueva materia prima (datos) solo es complementaria con un tipo escaso de habilidades, son los dueños de dichas habilidades los que se quedan la mayor parte del premio. Para que un país como España aprovechase las oportunidades de este nuevo mundo, habría de conseguir mejoras radicales y generalizadas en la formación en matemáticas, programación e inglés; de momento, España sigue en el vagón de cola de la educación en la OCDE.

Conclusión 2

Para que los avances del Big Data penetren de forma generalizada en la empresa, habrá de sortearse un problema fundamental: ¿quién será en cada empresa el encargado de decidir qué decisiones se pueden dejar a un modelo y cuáles no? Un modelo estadístico es algo muy opaco para el que no tiene la formación necesaria. En la anterior revolución, cualquier persona podía apreciar la facilidad con la que un martillo neumático perforaba el asfalto, cuantificar la ganancia de productividad y comprar la nueva maquinaria. El ejecutivo moderno, sin embargo, ha de decidir si confiar en los resultados de un modelo que probablemente no comprenda a la hora de tomar una decisión.

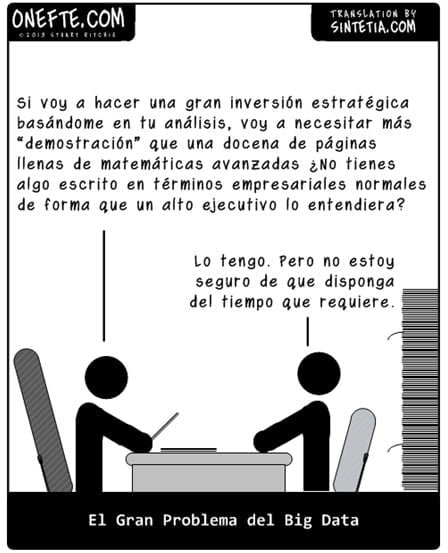

Un poco de humor nos ayuda a explicar aquí cómo vemos la realidad del Big Data en el plano empresarial. En Sintetia estrenamos sección de viñetas, traduciendo en exclusiva al español el cómic OneFTE – “Impresiones sobre la Vida Empresarial”, donde encontramos la siguiente viñeta que ilustra el problema a la perfección – La incomprensible verdad sobre el Big Data.

1 Comentario

Hola,

Gracias por el articulo.

Puedes comentar sobre los credit-score americanos (i.e. companyias que miran a sus bases de datos y dan un numero a cada ciudadano cuando este intenta pedir un credito, para predecir su probabilidad de impago/pago; lo que se traduce en diferentes tipos de interes del prestamo).