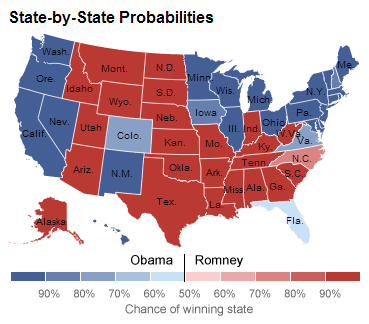

Finalmente, la gran noticia y sensación de las pasadas elecciones americanas no resultó ser, por extraño que parezca, ninguno de los dos candidatos, ni siquiera Obama, el vencedor. La mayor victoria se la anotaron los quants, los especialistas en análisis de datos, con Nate Silver a la cabeza -aunque no es el único ‘acertante de 15’; el Princeton Election Consortium también hizo pleno-.

Finalmente, la gran noticia y sensación de las pasadas elecciones americanas no resultó ser, por extraño que parezca, ninguno de los dos candidatos, ni siquiera Obama, el vencedor. La mayor victoria se la anotaron los quants, los especialistas en análisis de datos, con Nate Silver a la cabeza -aunque no es el único ‘acertante de 15’; el Princeton Election Consortium también hizo pleno-.

Nate Silver es un economista especialista en estadística cuyo blog –FiveThirtyEight, el número de votos de los colegios electorales en EEUU- sobre predicciones electorales basadas en datos había sido comprado cuatro años atrás por el NYTimes tras acertar los resultados de todos los estados exceptuando dos. Su track-record de predicciones ha incluso mejorado durante las presentes elecciones tras acertar los resultados de absolutamente todos los estados -algo que, como el propio Nate reconoce, tiene incluso un pequeño componente de azar; era más probable que su modelo fallase en algún estado que el hecho de que los acertase todos-.

El éxito de Nate Silver se ha cimentado sobre el de analistas expertos como Karl Rove, quienes basaban sus opiniones y predicciones en su supuesta capacidad interna para agregar e interpretar la opinión ciudadana. Y se ha cimentado también a costa del prestigio perdido por los analistas más partidistas, algunos de los cuales –obviamente los republicanos- acusaban a Silver de querer manipular al electorado mediante predicciones falsas. Una curiosa táctica para desacreditarle consistía en airear con fuerza los resultados de aquellas encuestas que inevitablemente aparecían mostrando la victoria republicana, ignorando deliberadamente que una encuesta con el 95% de fiabilidad arrojará un resultado erróneo una de cada veinte veces que se realice.

Su sencillo modelo consiste únicamente en la agregación de datos de encuestas individuales –con cada nueva encuesta publicada actualiza sus predicciones siguiendo un estimador bayesiano. El propio Silver ha reconocido reiteradamente que lo que hace no tiene ningún mérito especial más allá de la paciencia y el trabajo de recolectar datos y comprobar la robustez de sus modelos predictivos. Es por ello que su triunfo es, en realidad, la vindicación del papel de los analistas de datos en una sociedad compleja como la moderna.

La sabiduría de los datos versus la sabiduría de las masas

No obstante, la batalla por la forma más eficiente para agregar información no acaba aquí; solo empieza. Por ejemplo, en lugar de la intención de voto, podríamos agregar, como han hecho Justin Wolfers y David Rothschild, la información contenida en la pregunta “¿quién cree que va a ganar las elecciones?”. En un sentido estricto, no se trata de dos enfoques opuestos, sino de un enfoque complementario para utilizar datos disponibles con mayor valor informativo.

La clave de preguntarle a alguien lo que cree que va a suceder está en que su respuesta no se basará en sus preferencias personales, si no en la experiencia que tiene del mundo real a través de sus amigos, conocidos y de la información que asimila. Y en esto hay una diferencia abismal: si en mi mano estuviese la decisión, elegiría sin duda un proceso de paz duradero entre Israel y sus vecinos musulmanes; pero si lo que me preguntan es mi opinión sobre cómo estará la situación dentro de un año, diré honestamente que me temo que el conflicto seguirá aún vivo.

Wolfers y Rothschild, en su trabajo “Forecasting Elections: Voter Intentions versus Expectations” muestran como, extrapolando la precisión de las predicciones de los votantes, los encuestados se comportan como pequeños agregadores de información, promediando la información de unas 20 personas cuando se les hace la pregunta “¿Quién cree que ganará las elecciones?”

Como el propio Wolfers explica en un artículo en Bloomberg, los resultados tendrían también aplicación práctica para casos como el Marketing, ya que, si en vez de preguntar a cada persona concreta qué opina sobre un producto y qué aspectos se podrían mejorar se le preguntase acerca de la posible opinión de sus conocidos, los encuestados agregarían de la misma forma una información mucho más relevante para la empresa.

La Verdadera Nueva Era

Una nueva era se acerca, pero esta vez tendrá poco que ver con el postmodernismo y la duda permanente hacia el conocimiento objetivo. Se acerca una nueva era basada en el análisis de datos y en la agregación masiva de información. Hasta ahora, estas posibilidades y anhelos eran solo eso, posibilidades. Una cosa es que Google genere y almacene información de miles de millones de visitas y otra muy distinta es que sea capaz de poner en pie modelos operativos, tratables y útiles para su negocio –o, en definitiva, útiles para cualquier fin social-.

Las complejidades inherentes al tratamiento masivo de la información son mayúsculas. Por un lado, la información es un torrente de datos desestructurado el cual es necesario modelizar y darle una estructura teórica. En segundo lugar, la mayor parte de la información no procede de variaciones exógenas –como la forma en que se generan los experimentos-, sino que se trata de información observacional, es decir, de la información que generan los individuos al interaccionar con el resto de individuos de forma endógena. Sacar algo en claro de este tipo de información requiere un tipo de modelización estructural tremendamente compleja o atajos estadísticos (formas reducidas) con no pocos problemas de validez inferencial. Tercero, es necesario combinar la capacidad de modelización con las habilidades computacionales. Por último, aunque esto es cuestión de (poco) tiempo, el tratamiento masivo de datos requiere potencia masiva de computación y la adaptación de los paquetes estadísticos existentes.

Pero si hay algo cierto es que la capacidad de modelización está aumentando a gran velocidad, la capacidad de formación de las personas en estas técnicas se está multiplicando exponencialmente gracias a iniciativas como Coursera o EdX y, como antes indicábamos, la capacidad de computación crece a pasos agigantados (junto con la posibilidad de que cualquiera utilice dicha capacidad). Pronto comenzaremos a ver resultados reales.

2 Comentarios

¿Nos acercaremos a la Ciencia de la Psicohistoria de la que escribia Asimov en la saga Fundación?

Lo cierto es que cuantos más datos hay, la variabilidad disminuye. Lo que no es posible de predecir es el comportamiento de un individuo, en cambio cuanto mayor es la población, más preciso es el modelo.

Creo que la Utopía / Distopía de Asimov está muy lejos. Pero que cualquier paso en la dirección correcta dará muy buenos resultados. Bueno, en realidad ya los estamos dando, ¡solo que no somos ni conscientes!